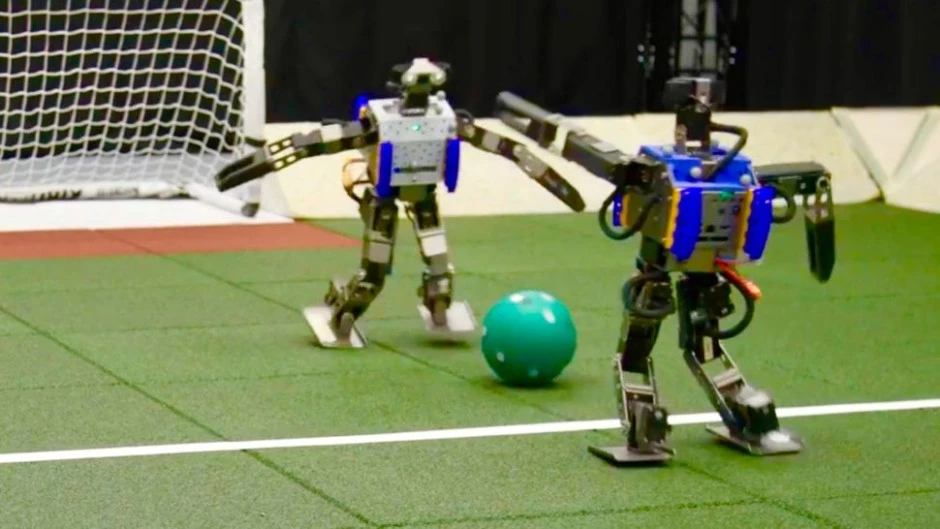

фото: Google Deepmind

Ученые научили миниатюрных роботов-гуманоидов играть в футбол, используя новый метод обучения искусственному интеллекту (ИИ). На кадрах видно, как роботы демонстрируют свои навыки в игре один на один.

В коротких роликах два двуногих робота играют в несколько игр, в которых один атакует ворота, а другой защищает их.

Они пинают мяч, блокируют удары и носятся по полю, размахивая руками и падая при этом. Но они, по крайней мере, стараются сохранять равновесие и быстро восстанавливаться после падения.

На первый взгляд может показаться, что это не так, но они также играют очень стратегически — изучают, как движется мяч, и предвидят следующие ходы противника, пытаясь перехитрить и опередить его, говорят ученые в своем исследовании.

Роботов-гуманоидов сложно настроить, потому что каждое движение необходимо запрограммировать, а это требует от ученых сбора огромных объемов данных. Однако многие современные роботы-гуманоиды получили помощь благодаря ИИ. Самообучение благодаря искусственному интеллекту будет означать, что роботам не понадобится ни одно движение, а движение заранее запрограммировано. Например, робот Рисунок 01 может учиться, просто просматривая видео — ранее ученые учили его готовить кофе, показывая ему всего 10 часов обучающих видеороликов.

В новом исследовании ученые Google DeepMind научили своих миниатюрных роботов Robotis OP3 играть в футбол, используя технику, называемую «глубокое обучение с подкреплением». Это метод машинному обучению, который сочетает в себе несколько различных методов обучения ИИ.

Этот коктейль техник включал в себя обучение с подкреплением, которое основано на виртуальном вознаграждении за достижение целей; контролируемое обучение; и глубокое обучение с использованием нейронных сетей — слоев алгоритмов машинного обучения, которые действуют как искусственные нейроны и устроены так, чтобы напоминать человеческий мозг.

Первоначально роботы отрабатывали заданный базовый набор навыков, прежде чем ученые применили свою комбинированную технику обучения ИИ с глубоким подкреплением.

В своих матчах роботы, обученные ИИ, ходили на 181% быстрее, поворачивались на 302% быстрее, били по мячу на 34% быстрее и тратили на 63% меньше времени на восстановление после падения, когда они теряли равновесие, по сравнению с роботами, не обученными с использованием этой техники. - заявили ученые в своей статье.

Роботы также разработали «экстренное поведение», которое было бы чрезвычайно сложно запрограммировать, например, поворот на уголке стопы и вращение вокруг, добавили они.

Результаты показывают, что этот метод обучения ИИ можно использовать для создания простых, но безопасных движений гуманоидных роботов в целом, что затем может привести к более сложным движениям в меняющихся и сложных ситуациях, говорят ученые.

Источник: Science Robotics

Комментарии

Чтобы оставить комментарий зарегистрируйтесь или войдите

Авторизация через