фото: https://www.linkedin.com/posts/alexwang2911_ai-aitools-productivity-activity-7305945206099521537-GWYk?utm_source=social_share_send&utm_medium=member_desktop_web&rcm=ACoAAC89kNwBXkVRAajr1yQHjfY78h85ckalX9k

Использование чат-ботов, таких как ChatGPT, стало привычным для множества пользователей по всему миру. Однако проблема заключается не в запросах или самих моделях, а в качестве тех данных, на которых эти модели обучаются. Интернет, с одной стороны, является источником огромного количества информации, но большая её часть — это посредственные и не всегда проверенные данные. Когда мы используем ИИ для генерации контента, мы фактически «усредняем» информацию до уровня интернета, где встречаются как золото, так и посредственность.

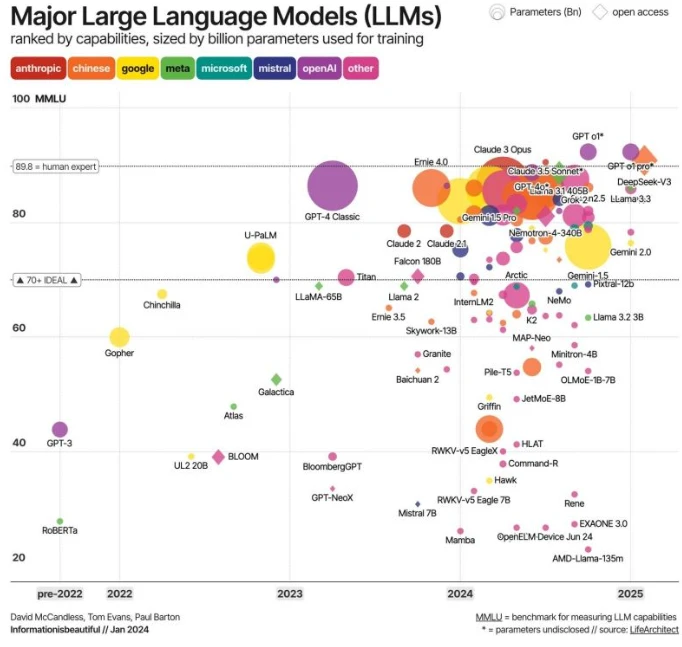

Как же можно улучшить результат, чтобы он был не только быстрым, но и качественным? Ответ заключается в том, чтобы не полагаться исключительно на большие языковые модели (LLM), а воспользоваться специальным рабочим процессом, который позволяет гарантировать высокое качество входных данных.

Вот такой рабочий процесс можно адаптировать под другие инструменты:

1) Semantic Scholar / Elicit — поиск актуальных академических исследований по запросу

Вместо того чтобы задавать ChatGPT общие вопросы, я использую Semantic Scholar или Elicit для поиска рецензируемых научных статей с высокой цитируемостью. Эти платформы предоставляют доступ к качественным исследованиям и позволяют получать более глубокие и надежные данные.

2) NotebookLM — загрузка и обработка научных статей для извлечения ключевых идей и создания структурированных знаний

Затем я использую NotebookLM, чтобы загрузить и обработать найденные исследования. Это инструмент позволяет не только извлекать важные инсайты из текста, но и превращать их в структурированную информацию, с которой легко работать. Это также дает возможность задавать конкретные вопросы, чтобы получить самые релевантные данные, что значительно повышает точность.

Теперь у нас есть высококачественные входные данные для работы.

3) ChatGPT (или другие модели, такие как Claude или Gemini)

На основе собранных исследований и структурированных данных я использую ChatGPT или другие языковые модели, такие как Claude или Gemini, чтобы превратить полученные инсайты в рабочие рамки и практические рекомендации. Эти инструменты помогут преобразовать научные результаты в легко воспринимаемый контент или выводы, которые можно применить на практике.

Важно отметить, что Semantic Scholar и NotebookLM являются бесплатными инструментами, что делает их доступными для широкого круга пользователей. Модуль Deep Research Mode в ChatGPT также предлагает хорошие возможности для более глубоких исследований, однако, он менее гибок в контроле качества входных данных и более подходит для быстрого анализа и поверхностных исследований.

Почему это важно?

Данный рабочий процесс позволяет избежать распространённой проблемы, когда контент, генерируемый ИИ, становится поверхностным или неточным из-за низкокачественных данных. Когда вы начинаете с высококачественных академических исследований и тщательно структурируете информацию, результат будет намного более точным и полезным, что поможет в создании контента с реальной ценностью.

Заключение

В то время как ИИ и большие языковые модели, такие как ChatGPT, предоставляют уникальные возможности для ускорения обработки информации, важно помнить, что их эффективность напрямую зависит от качества входных данных. Используя научные ресурсы, такие как Semantic Scholar и NotebookLM, вы можете существенно повысить качество генерируемого контента и получать не только быстрые, но и точные и обоснованные результаты. Системный подход, основанный на качественных данных, поможет вам получать более глубокие и полезные инсайты, которые можно применить в реальных ситуациях.

Не забывайте, что путь к успешному применению ИИ — это не только использование самой модели, но и правильная подготовка входных данных!

Комментарии

Чтобы оставить комментарий зарегистрируйтесь или войдите

Авторизация через